Wie lange muss ein A/B-Test laufen? Wie viel Traffic brauchen wir mindestens? Und an wie viel % der User sollte die Testversion ausgespielt werden? Diese Fragen habe ich diese Woche von einem meiner Coaching-Kunden gestellt bekommen. Und so gerne ich darauf eine pauschale Antwort geben möchte, ist es doch nicht ganz so einfach.

Grundsätzlich gilt für A/B-Tests, dass diese mindestens zwei Wochen laufen sollten, um Wetter- und/oder Tageszeitenbedingte Schwankungen auszugleichen. Damit hat man also schon mal das Minimum definiert.

Und bei der Ermittlung des Maximums gilt: Der Test sollte so lange laufen, bis er signifikante Ergebnisse liefert, also mindestens eine Wahrscheinlichkeit von 95% besteht, dass eine Variante besser performt hat. Und dies lässt sich leider nur annäherungsweise erahnen und ist prinzipiell von drei Faktoren abhängig:

- Besucher auf der Testvariante pro Tag

- Aktuelle Conversion

- Erwartete Steigerung der Conversion

Wenn man diese Werte hat, ist die Sache recht einfach und man kann einen der zahlreichen Signifikanz-Rechner verwenden, um die Dauer annäherungsweise zu bestimmen (Ich nutze bspw. den Rechner von converletics).

Genau darin liegt aber die Herausforderung, da es gar nicht so einfach ist, diese Werte zu ermitteln.

Schauen wir sie uns daher im Detail an.

Wie ermittle ich die Besucher auf der Testvariante pro Tag?

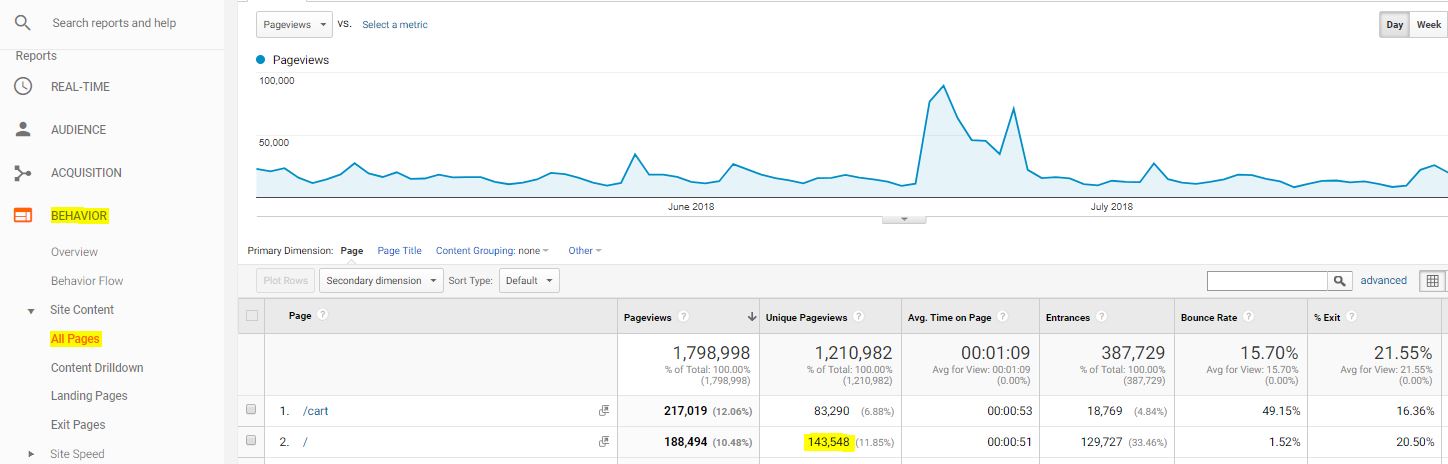

Die Besucher auf der Testvariante pro Tag zu ermitteln, klingt erstmal einfach. Bei genauerem Hinsehen ist sie es dann leider aber nicht. Zumindest nicht, wenn man den A/B-Test nur auf einer bestimmten Seite durchführen möchte und Google Analytics im Einsatz hat. Zwar findet man dort über Verhalten > Seiteninhalt > Alle Seiten die Zugriffe auf die Seite, allerdings nicht die tatsächlichen Besucher. Diese gibt Google Analytics auf Seitenebene nicht her.

Am nächsten dran ist daher die Metrik Unique Pageviews, da aus dieser „die Anzahl der Sessions, die die Seite mindestens einmal aufgerufen haben“ hervorgeht. Da ein Besucher auch mehrere Sessions haben kann (bspw. wenn diese nach einer gewissen Zeit der Inaktivität endet), ist sie nicht 100% genau, aber anders werden es die A/B-Testing-Tools vermutlich auch nicht ermittelt bekommen.

Für diese ermittelt man also den täglichen Durchschnitt und teilt diese durch die Anzahl der Testvarianten (also bei einem klassischen A/B-Test durch 2).

Ggbfs. sollte man sich dies auch separat für Mobile- und Desktop-Traffic anschauen. Vor allem, wenn man plant, nur auf einem Device zu testen.

Wie ermittle ich die durchschnittliche Conversionrate?

Die durchschnittliche Conversionrate ist dann recht einfach entweder über Conversion > E-Commerce > Overview oder (falls man keinen Shop hat) über Aquisition > All Traffic > Channels zu finden (oder halt den entsprechenden deutschen Begriffen ;)). Auch hier gilt, sich diese getrennt nach Desktop und Mobile anzuschauen, da es dort meistens gravierende Unterschiede gibt.

Welche Veränderung kann ich erwarten?

Die erwartete Veränderung können wir dann leider nur erahnen. Der Rechner gibt hier als Vorgabe 25% für große Veränderungen anzugeben und 15% für kleine.

Ganz so einfach ist es dann aber nicht, da die erwartete Veränderungen von mehreren Faktoren abhängt:

- Wie hoch ist der Kontrast der Testvariante? Also wie stark unterscheidet sich die Testvariante von der Originalvariante? Gibt es hier nur kleine Veränderungen, wird auch die Conversionrate nur minimal steigen. Gibt es einen hohen Kontrast, kann die Conversionrate auch einen großen Sprung in die eine oder eben andere Richtung machen.

- Wie weit ist die Seite vom Conversionziel entfernt? Je weiter eine Seite vom Conversionziel entfernt ist, umso geringer sind auch die Auswirkungen auf eine Steigerung. Einfach deshalb, weil dazwischen noch recht viel passieren kann (Häufig ist daher das Ziel, die Bounce- oder Absprungrate auf einer Landingpage zu reduzieren, ein lohnenderes Ziel. Diese Metriken lassen sich aber über den Rechner nicht berücksichtigen).

- Wie hoch ist die aktuelle Conversionrate? Ist die aktuelle Conversionrate schon recht hoch, dann wird eine hohe Steigerung nicht mehr unbedingt zu erwarten sein. Da geht es dann häufig „nur“ noch um Kleinigkeiten und die haben häufig dann ja keinen sichtbaren Kontrast zur Originalvariante mehr (womit wir wieder bei Punkt 1 sind).

Was mache ich mit den Zahlen?

Wenn man die Zahlen ansatzweise ermittelt hat, gibt man diese in den Rechner ein und erhält eine ungefähre Laufzeit. Diese ist aber wirklich nur als Orientierung zu nehmen. Am Ende entscheidet das A/B-Testing-Tool, wann ein vorher definiertes Signifikanzniveau erreicht ist. Häufig werden hier 95% angesetzt, was im Umkehrschluss immer noch bedeutet, dass das Ergebnis mit einer Wahrscheinlichkeit von 5% falsch sein könnte. Wer es da genauer wissen will, setzt 99% an, wodurch sich dann aber auch die Dauer erhöht.

Gibt es eine Dauer, die nicht überschritten werden sollte?

Ja. Grundsätzlich sollte ein Test nicht länger als 6 Wochen laufen. Läuft er zu lange, kann er durch saisonale Schwankungen oder Marketing-Aktionen beeinflusst werden. Auch muss man beim Testing von neuen Funktionen oder Bugfixes immer im Auge behalten, dass der A/B-Test nachher auch immer noch genauso wie vorher funktioniert. Spuckt ein Signifikanz-Rechner daher Laufzeiten von über 42 Tage aus, braucht man sich gar nicht mehr damit beschäftigen, ob man die Traffic-Verteilung bei weniger als 50% ansetzt.